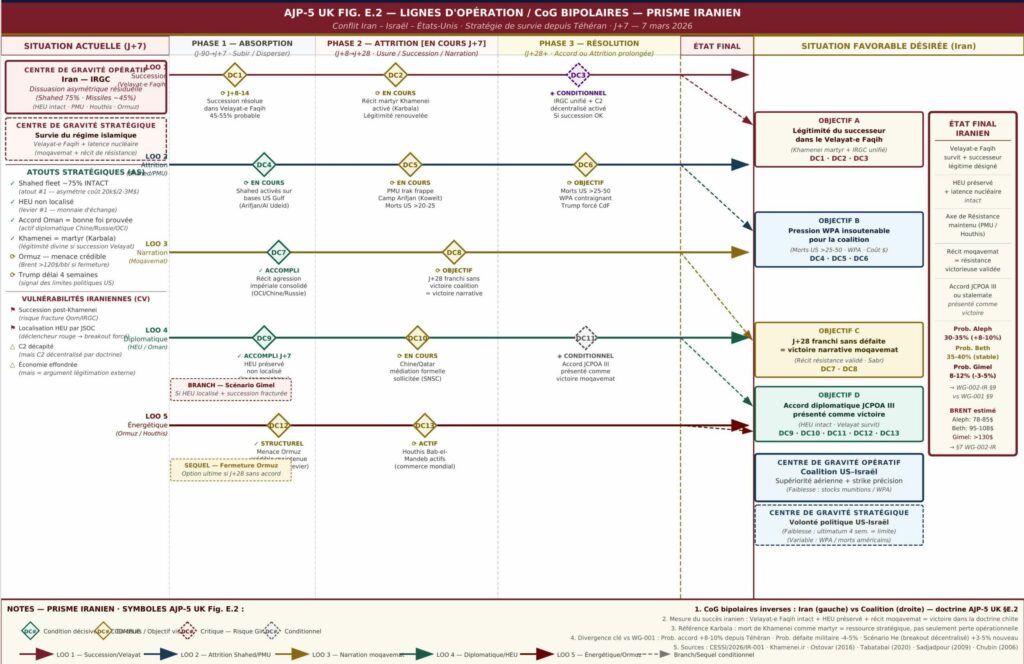

Etude stratégique conflit Iran

Wargame stratégique : Iran – Israel – USA

Digital Forge: Burying the “Factory” and Industrializing Boldness

Let’s start with an execution… a linguistic one.

“Digital factory” sounds like a guided tour: hi-vis vests, an Agile poster, and a POC that “has enormous potential” (since 2019). “Digital forge,” on the other hand, sounds like a promise: fire, constraint, quality control — and a part that holds under load.

This isn’t a semantic whim. Organizations behave exactly like their metaphors. A factory “produces” when everything is stable. A forge “transforms” when reality is hostile.

And spoiler (without spoiling): reality is hostile.

Why now: digital is no longer a support function, it’s an operating environment

In complex organizations, digital transformation is no longer an “initiative.” It’s a permanent capability. The issue isn’t having ideas. The issue is converting ideas into deployed, maintained, secured, and interoperable capabilities.

You can already see it in three very concrete symptoms:

- We innovate fast… then stall at the moment of scaling.

- We accumulate standards… then get outrun by shadow IT (and now shadow AI).

- We “govern” a lot… but deliver little (or deliver fragile).

The Digital Forge targets precisely these breaking points.

Definition (simple): a Digital Forge is not a “lab”

A Digital Forge is a socio-technical system that makes the following path natural:

innovation → experimentation → hardening → production → scale

No reset. No “taking back control.” No “now we’re going to industrialize” as if it were a different universe.

A serious forge stands on three pillars:

- A paved road: what is compliant must be simpler than what isn’t.

- An internal platform designed as a product: reduce cognitive load on teams, avoid duplication, accelerate.

- Fluid governance: few committees, many encoded rules, and fast decisions.

🧾 The killer test (in 15 seconds)

If your “forge”:

- requires a 40-page dossier,

- mandates 5 committees,

- and promises “a go-live in 6 months”…

It’s not a forge. It’s a slowness factory with a new logo.

The real problem: the valley of death between POC and production

The graveyard of modern organizations isn’t filled with bad ideas. It’s filled with good ideas that were never industrialized.

Why does it break?

- Because a prototype proves neither security, nor operability, nor maintainability.

- Because compliance shows up “at the end.”

- Because the real architecture isn’t known (dependencies, flows, identities, data).

- Because nobody has the mandate — nor the tooling — to convert the try.

A forge worthy of the name doesn’t “celebrate” innovation. It makes it survive.

Shadow IT / Shadow AI: the forge as antidote (not as police)

Shadow IT isn’t deviance. It’s a rational response to an organization that’s too slow.

Generative AI just strapped a turbo on it. If the outside moves faster than the inside, usage will happen anyway — but off-framework, off-logs, off-protection, off-truth.

The forge responds by design:

- ready-made environments,

- governed internal models and tools,

- built-in guardrails (identity, secrets, traceability, logs),

- and a UX that doesn’t humiliate the user.

The principle is simple: make the right path easier than the wrong one.

The digital twin: the piece that changes the scale

You insisted on a key point: a modern forge cannot scale without a living representation of the organization.

A Digital Twin of the Organization (DTO), forge version, isn’t a mockup. It’s a dynamic map:

- applications, flows, dependencies,

- data architecture,

- IAM, access paths, trust zones,

- operational signals (observability, incidents, vulnerabilities, costs),

- ownership (who operates what, where, with what constraints).

Why is it decisive?

Because scaling rarely fails due to lack of talent. It fails due to unknowns. The DTO reduces unknowns. And when you reduce unknowns, you accelerate without breaking things.

Security: the “grandfather” rule (approval inheritance)

Your “grandfather rule” is an excellent strategic intuition: if you forge from already-approved building blocks, you inherit part of the assurance.

In concrete terms:

- the platform provides already-hardened components (IAM, encryption, logs, CI/CD, templates, patterns),

- each product only proves its differential (data, exposure, usage),

- proof is automated as much as possible.

Caveat: inheritance ≠ immunity. But inheritance = methodical acceleration.

This is exactly how you make security compatible with speed: you put it in the alloy, not in the final rubber stamp.

Governance: MHacker + super-facilitators (otherwise it degenerates)

A forge is a social system before it is a technical system.

The choice of “MHacker” governance (Maker + Hacker) [LinkedIn reference] is highly relevant: people capable of prototyping fast and industrializing cleanly, arbitrating without lying, and staying obsessive about scaling.

But there’s often a missing rare role: the super-facilitator (in the HBR sense: [HBR France reference]). Not a meeting facilitator. A multiplier of collective performance.

Their job in a forge:

- prevent “dev vs. security vs. architecture vs. ops” wars,

- distribute voice and intelligence (not politics),

- accelerate tough trade-offs,

- maintain trust without lowering the bar.

Without super-facilitation, a multidisciplinary forge quickly turns into a courtroom: everyone pleads their doctrine, nobody forges.

🧾 The paradox that kills foundries

The more experts you put around the table, the more you increase:

- the potential quality of the decision,

- and the probability of never deciding.

The super-facilitator exists to break this paradox without breaking the expertise.

Federating labs: creative archipelago, industrial backbone

You don’t want to centralize. You want to federate. That’s exactly the mature approach:

- labs close to the field (exploration, weak signals, prototyping),

- a forge that provides the backbone (platform, security, standards, patterns),

- a clear handoff when an idea becomes a product.

Federation isn’t a “club.” It’s a pipeline: many inputs, one common path to scale.

The quiet (but very telling) signal

When organizations constrained by multinational interoperability, security, and industrial complexity institutionalize a “foundry,” it’s not for show.

It’s a signal: the problem is no longer “innovate.” The problem is “industrialize fast, safe, and together.”

Keep this idea in the back of your mind. It makes the manifesto less theoretical… and far more inevitable.

Operating Model (anti-bureaucratic layer)

The Forge as a “highway”: fast by default, controlled by design

The operating model must project a feeling: fluidity. If the reader sees “new bureaucracy,” it’s a failure.

Here, governance isn’t a layer. It’s a highway code.

1) The promise (what the Forge guarantees)

- In less than a day: start a product on a ready-made foundation (repo + CI/CD + environments + IAM + logs).

- In a few days: a deployable pre-prod with minimal evidence (tests, scans, initial runbook).

- In a few weeks: production without reinventing security, operations, and architecture.

The forge doesn’t “validate.” It makes things possible.

2) The autonomy contract (short and non-negotiable)

The Forge provides:

- golden paths (templates + pipelines + patterns + docs),

- approved building blocks (“grandfather” inheritance),

- short-burst support (office hours, pairing, enabling).

Product teams commit to:

- keeping ownership (build/run/own),

- producing minimal evidence (automated),

- documenting structural decisions (short ADRs).

3) Invisible governance (the kind that doesn’t scare people)

- By default: highway (golden path) → fast lane.

- Highway exit: allowed, but with “equivalent proof” + traceability + end date.

An exception without an end date isn’t an exception: it’s debt.

4) Three rituals max (otherwise it’s a bureaucracy)

- Forge office hours (weekly, 60 min): unblock, help, disseminate patterns.

- Exception review (bi-weekly, 45 min timebox): decide fast, enforce a sunset.

- Platform review (monthly, 60 min): prioritize the platform backlog from field irritants.

Everything else is asynchronous and encoded.

5) Decisions with SLAs (otherwise the forge becomes a bottleneck)

- Minor exception: decision in 48 hours

- Major exception: decision in 10 days (with options, not with “come back with a dossier”)

- Critical incident: immediate, then systemic learning.

6) Super-facilitator: the anti-friction role

Positioned at the interfaces (product ↔ cyber ↔ architecture ↔ ops ↔ procurement), they ensure that multidisciplinarity produces decisions — not friction.

7) Minimal evidence: evidence, not paperwork

- CI/CD with relevant scans

- Observability activated (logs/metrics/traces)

- Nominal + degraded runbook

- 1-page ADR on structural decisions

- DTO fed automatically, supplemented if needed

8) Anti-theater metrics

- DORA (throughput + stability)

- Golden path adoption

- Exception debt (volume + age)

- Shadow IT/AI: detected vs. repatriated, with root causes

Conclusion

An organization can survive for a long time with labs, POCs, and showcase “factories.” It doesn’t become more sovereign. It just gets better at telling the story that it is.

The Digital Forge changes the nature of the game: it turns innovation into durable capability, and governance into encoded fluidity. A forge doesn’t promise quality. It produces it — and it reproduces it.

Forge Numérique : enterrer la “fabrique” et industrialiser l’audace

On va commencer par une exécution… linguistique.

“Fabrique numérique” sonne comme une visite guidée : gilets fluos, poster Agile, et un POC qui “a un potentiel énorme” (depuis 2019). “Forge numérique”, elle, sonne comme une promesse : du feu, de la contrainte, du contrôle qualité — et une pièce qui tient sous charge.

Ce n’est pas un caprice sémantique. Les organisations se comportent exactement comme leurs métaphores. Une fabrique “produit” si tout est stable. Une forge “transforme” quand le réel est hostile.

Et spoiler (sans spoiler) : le réel est hostile.

Pourquoi maintenant : le numérique n’est plus un support, c’est un milieu

Dans les organisations complexes, la transformation numérique n’est plus une “initiative”. C’est une capacité permanente. Le sujet n’est pas d’avoir des idées. Le sujet est de convertir des idées en capacités déployées, maintenues, sécurisées et interopérables.

Vous le voyez déjà dans trois symptômes très concrets :

- On innove vite… puis on cale au moment du passage à l’échelle.

- On accumule des standards… puis on se fait doubler par le shadow-IT (et maintenant le shadow-AI).

- On “gouverne” beaucoup… mais on livre peu (ou on livre fragile).

La Forge Numérique vise précisément ces points de rupture.

Définition (simple) : une Forge Numérique n’est pas un “lab”

Une Forge Numérique est un système socio-technique qui rend naturel le passage :

innovation → expérimentation → durcissement → production → échelle

Sans reset. Sans “reprise en main”. Sans “maintenant on va industrialiser” comme si c’était un autre univers.

Une forge sérieuse tient sur trois piliers :

- Un chemin pavé (“paved road”) : ce qui est conforme doit être plus simple que ce qui ne l’est pas.

- Une plateforme interne pensée comme un produit : on réduit la charge cognitive des équipes, on évite la duplication, on accélère.

- Une gouvernance fluide : peu d’instances, beaucoup de règles encodées, et des décisions rapides.

🧾Le test qui tue (en 15 secondes)

Si votre “forge” :

- demande un dossier de 40 pages,

- impose 5 comités,

- et promet “un passage en production en 6 mois”…

Ce n’est pas une forge. C’est une fabrique de lenteur avec un nouveau logo.

Le vrai problème : la vallée de la mort entre POC et production

Le cimetière des organisations modernes n’est pas rempli de mauvaises idées. Il est rempli de bonnes idées jamais industrialisées.

Pourquoi ça casse ?

- Parce qu’un prototype ne prouve ni la sécurité, ni l’exploitabilité, ni la maintenabilité.

- Parce que la conformité arrive “à la fin”.

- Parce que l’architecture réelle n’est pas connue (dépendances, flux, identités, données).

- Parce que personne n’a le mandat — ni l’outillage — pour transformer l’essai.

Une forge digne de ce nom ne “célèbre” pas l’innovation. Elle la fait survivre.

Shadow-IT / Shadow-AI : la forge comme antidote (pas comme police)

Le shadow-IT n’est pas une déviance. C’est une réponse rationnelle à une organisation trop lente.

L’IA générative a juste mis un turbo. Si l’extérieur va plus vite que l’intérieur, l’usage se fera quand même — mais hors cadre, hors logs, hors protection, hors vérité.

La forge répond par design :

- des environnements prêts,

- des modèles et outils internes encadrés,

- des garde-fous intégrés (identité, secrets, traçabilité, logs),

- et une UX qui n’humilie pas l’utilisateur.

Le principe est simple : rendre le bon chemin plus facile que le mauvais.

Le jumeau numérique : la pièce qui change l’échelle

Vous avez insisté sur un point clé : une forge moderne ne peut pas passer à l’échelle sans une représentation vivante de l’organisation.

Un Digital Twin of the Organization (DTO), version forge, ce n’est pas une maquette. C’est une carte dynamique :

- applications, flux, dépendances,

- architecture data,

- IAM, chemins d’accès, zones de confiance,

- signaux opérationnels (observabilité, incidents, vulnérabilités, coûts),

- ownership (qui opère quoi, où, avec quelles contraintes).

Pourquoi c’est déterminant ?

Parce que l’échelle échoue rarement par manque de talent. Elle échoue par inconnu. Le DTO réduit l’inconnu. Et quand on réduit l’inconnu, on accélère sans casser.

Sécurité : la règle du “grand-père” (héritage d’approbation)

Votre “règle du grand-père” est une excellente intuition stratégique : si vous forgez à partir de briques déjà approuvées, vous héritez d’une partie de l’assurance.

Traduction concrète :

- la plateforme fournit des composants déjà durcis (IAM, chiffrement, logs, CI/CD, templates, patterns),

- chaque produit ne prouve que son différentiel (données, exposition, usage),

- on automatise la preuve autant que possible.

Attention : héritage ≠ immunité. Mais héritage = accélération méthodique.

C’est exactement ainsi qu’on rend la sécurité compatible avec la vitesse : on la met dans l’alliage, pas dans le tampon final.

Gouvernance : MHacker + super-facilitateurs (sinon ça dégénère)

Une forge est un système social avant d’être un système technique.

Le choix d’une gouvernance “MHacker” (Maker + Hacker) [https://www.linkedin.com/pulse/pourquoi-les-organisations-ont-besoin-de-mhackers-de-san-nicolas-syvce/] est très pertinent : des gens capables de prototyper vite et d’industrialiser propre, d’arbitrer sans mentir, et de rester obsessionnels sur le passage à l’échelle.

Mais il manque souvent un rôle rare : le super-facilitateur (au sens HBR : https://www.hbrfrance.fr/management/toutes-les-equipes-ont-besoin-dun-super-facilitateur-61180). Pas un animateur de réunion. Un multiplicateur de performance collective.

Son job dans une forge :

- éviter les guerres “dev vs sécu vs archi vs ops”,

- distribuer la parole et l’intelligence (pas la politique),

- accélérer les arbitrages difficiles,

- maintenir la confiance sans baisser l’exigence.

Sans super-facilitation, une forge pluridisciplinaire se transforme vite en tribunal : chacun plaide sa doctrine, personne ne forge.

🧾 Le paradoxe qui tue les foundries

Plus vous mettez d’experts autour de la table, plus vous augmentez :

- la qualité potentielle de la décision,

- et la probabilité de ne jamais décider.

Le super-facilitateur existe pour casser ce paradoxe sans casser l’expertise.

Fédérer les labs : archipel créatif, colonne vertébrale industrielle

Vous ne voulez pas centraliser. Vous voulez fédérer. C’est exactement l’approche mature :

- des labs proches du terrain (exploration, signaux faibles, prototypage),

- une forge qui fournit la colonne vertébrale (plateforme, sécurité, standards, patterns),

- un passage de relais clair quand une idée devient produit.

La fédération n’est pas un “club”. C’est un pipeline : beaucoup d’entrées, un chemin commun vers l’échelle.

Le signal discret (mais très parlant)

Quand des organisations contraintes par l’interopérabilité multinationale, la sécurité, et la complexité industrielle institutionnalisent une “foundry”, ce n’est pas pour faire joli.

C’est un signal : le problème n’est plus “innover”. Le problème est “industrialiser vite, sûr, et ensemble”.

Gardez cette idée en arrière-plan. Elle rend le manifeste moins théorique… et beaucoup plus inévitable.

Modèle opératoire (anti-couche bureaucratique)

La Forge comme “autoroute” : rapide par défaut, contrôlée par design

Le modèle opératoire doit projeter une sensation : fluidité. Si le lecteur voit “nouvelle bureaucratie”, c’est raté.

Ici, la gouvernance n’est pas un étage. C’est un code de la route.

1) La promesse (ce que la Forge garantit)

- En moins d’une journée : démarrer un produit sur un socle prêt (repo + CI/CD + environnements + IAM + logs).

- En quelques jours : une pré-prod déployable avec preuves minimales (tests, scans, runbook initial).

- En quelques semaines : production sans réinventer sécurité, exploitation et architecture.

La forge ne “valide” pas. Elle rend possible.

2) Le contrat d’autonomie (court et non négociable)

La Forge donne :

- des golden paths (templates + pipelines + patterns + docs),

- des briques approuvées (héritage “grand-père”),

- un support court (office hours, pairing, enabling).

Les équipes produit s’engagent à :

- garder l’ownership (build/run/own),

- produire les preuves minimales (automatisées),

- documenter les choix structurants (ADR courts).

3) La gouvernance invisible (celle qui ne fait pas peur)

- Par défaut : autoroute (golden path) → passage rapide.

- Sortie d’autoroute : autorisée, mais avec “preuve équivalente” + traçabilité + date de fin.

Une exception sans date de fin n’est pas une exception : c’est une dette.

4) Trois rituels max (sinon c’est une administration)

- Office hours Forge (hebdo, 60 min) : débloquer, aider, diffuser des patterns.

- Revue des exceptions (toutes les 2 semaines, 45 min timebox) : trancher vite, imposer un sunset.

- Revue plateforme (mensuel, 60 min) : prioriser le backlog plateforme à partir des irritants terrain.

Le reste est asynchrone et encodé.

5) Décisions avec SLA (sinon la forge devient un goulot)

- Exception mineure : décision en 48 h

- Exception majeure : décision en 10 jours (avec options, pas avec “revenez avec un dossier”)

- Incident critique : immédiat, puis apprentissage systémique.

6) Super-facilitateur : le rôle anti-frottement

Positionné aux interfaces (produit↔cyber↔archi↔ops↔achats), il garantit que la pluridisciplinarité produit des décisions — pas des frictions.

7) Les preuves minimales : evidence, pas paperasse

- CI/CD avec scans pertinents

- Observabilité activée (logs/metrics/traces)

- Runbook nominal + dégradé

- ADR 1 page sur choix structurants

- DTO alimenté automatiquement, complété si nécessaire

8) Indicateurs anti-théâtre

- DORA (débit + stabilité)

- Adoption des golden paths

- Dette d’exceptions (volume + âge)

- Shadow IT/AI : détecté vs rapatrié, avec causes racines

Conclusion

Une organisation peut survivre longtemps avec des labs, des POC et des “fabriques” vitrines. Elle ne devient pas plus souveraine. Elle devient juste plus douée pour raconter qu’elle l’est.

La Forge Numérique, elle, change la nature du jeu : elle transforme l’innovation en capacité durable, et la gouvernance en fluidité encodée. Une forge ne promet pas la qualité. Elle la produit — et elle la reproduit.

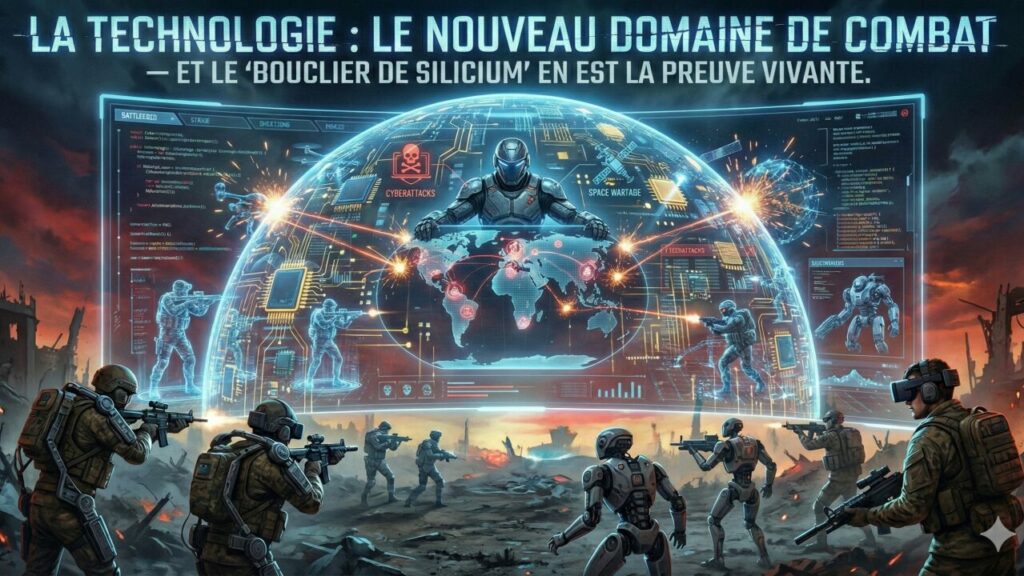

La Nouvelle Ligne de Front : la Technologie est un Domaine de Combat — et le “Bouclier de Silicium” en est la preuve vivante

La façon la plus confortable de parler de technologie en défense consiste à la traiter comme un “support” : utile, certes, mais périphérique. Dans cette article : https://www.csis.org/analysis/new-frontline-technology-modern-warfighting-domain, le CSIS propose l’idée inverse : la science et la technologie sont désormais un domaine de combat à part entière. Perdre la maîtrise technologique, c’est perdre du terrain — avant même le premier tir.

Taïwan rend la thèse instantanément concrète. Le “bouclier de silicium” (silicon shield) désigne l’idée que la centralité taïwanaise dans les semi-conducteurs crée une dissuasion par interdépendance : casser Taïwan, c’est casser une partie du monde numérique. Les chiffres du Trade.gov sont sans ambiguïté : Taïwan pèse “plus de 60 %” du revenu mondial des fonderies et “plus de 90 %” du leading-edge. Dans un univers où tout, de l’IA aux missiles, dépend de puces avancées, cette concentration n’est pas un fait économique : c’est un fait stratégique, donc un levier potentiel de coercition, de dissuasion… et de crise.

1️⃣ L’avertissement : la compétition se joue sur le tempo Le message du CSIS n’est pas “il faut plus d’innovation”. Il est plus corrosif : l’avantage ira à ceux qui sauront manœuvrer dans un environnement technologique contesté, en compressant les boucles d’apprentissage. Les communications autour de l’article insistent sur ce risque simple : considérer la technologie comme un sujet annexe, c’est accepter de “céder un terrain clé” dans le prochain conflit.

Cela change la nature même de l’avantage. Dans les conflits récents, la supériorité ne vient pas seulement de “posséder” une capacité, mais de la capacité à la faire évoluer sous contrainte, au contact, dans un duel d’adaptation. Le facteur décisif devient la cadence : observer, décider, agir, apprendre… puis recommencer avant l’adversaire.

2️⃣ “Domaine technologique” : un écosystème contesté, pas un gadget Un domaine militaire, c’est un espace où l’on recherche la liberté d’action et où l’on conteste celle de l’adversaire. La technologie devient un domaine quand elle produit des effets, quand elle peut être contestée, et quand elle conditionne les autres domaines.

Ce domaine s’organise en trois couches qui s’imbriquent.

Matériel : capteurs, calculateurs, réseaux, énergie, semi-conducteurs. Ici, Taïwan est un centre de gravité industriel : l’International Trade Administration rappelle qu’en 2024 l’industrie taïwanaise a généré plus de 165 Md$ et qu’une grande partie des concepteurs américains dépend des capacités de fabrication avancée locales.

Logiciel : code, mises à jour, interopérabilité, cybersécurité. Le logiciel est une boucle d’apprentissage : sans capacité de mise à jour rapide, la puissance se fige, la vulnérabilité augmente, et l’adversaire récupère l’initiative par l’attrition logicielle.

Informationnel et cognitif : données, algorithmes, modèles, transparence et influence. L’Ukraine illustre cette “guerre de la vitesse informationnelle” : sources ouvertes, imagerie commerciale et IA accélèrent l’action, et “celui qui apprend le plus vite” prend l’avantage.

Le point important, stratégiquement, est que ces couches ne s’additionnent pas : elles se multiplient. Dans un écosystème, une faiblesse de la chaîne (puces, énergie, liaisons, code, IAM, data) peut annuler un avantage local. C’est la logique des centres de gravité interconnectés : on ne “gagne” pas un domaine en optimisant un seul composant.

3️⃣ Le triptyque qui écrase le terrain : autonomie, drones, guerre électronique Le brouillon (et le CSIS qu’il synthétise) pointe un triptyque devenu incontournable : autonomie (au sens large), prolifération des systèmes sans pilote (notamment sUAS), et retour massif de la guerre électronique/spectre. C’est une guerre de la détection et de la liaison : capter, transmettre, décider, frapper… puis survivre au contre-coup.

La RUSI décrit comment la lutte drones / EW structure des dynamiques tactiques et opérationnelles : les UAV servent à identifier les positions de guerre électronique, lesquelles deviennent des cibles prioritaires intégrées ensuite à des feux multi-moyens. La technologie ne “s’ajoute” pas à la manœuvre : elle redessine le champ de bataille, et elle redéfinit aussi le coût des erreurs. Une architecture fragile n’est pas seulement “moins efficace” : elle peut devenir un multiplicateur de pertes.

4️⃣ Transparence radicale : la fin du monopole de l’observation Le brouillon parle de “transparence radicale”. C’est une formule utile, parce qu’elle décrit une rupture durable : l’observation du champ de bataille n’est plus réservée aux États. La disponibilité de services commerciaux et de communautés OSINT change la vitesse de détection, de vérification et de diffusion. Dans son discours sur l’Ukraine, le général Hockenhull explique que les satellites commerciaux étendent la connaissance de la situation, que l’IA accélère l’action, et que la victoire dépend de la capacité à sentir, décider, agir et apprendre avec suffisamment de vitesse pour dépasser l’adversaire.

Cette transparence ne fait pas disparaître le brouillard : elle le transforme. Elle augmente la quantité de signaux, donc le risque d’erreurs, de manipulations, et de “biais de disponibilité”. Mais elle impose deux conséquences très opérationnelles : (1) la protection et la déception doivent être repensées (signature management, opsec, leurres), (2) la maîtrise du récit et de la preuve devient un enjeu de coalition (partage, déclassification, crédibilité).

5️⃣ Le chaînon manquant : l’opérationnel technologique Nous parlons beaucoup de technologie au niveau stratégique (souveraineté, alliances, investissements) et nous la vivons au niveau tactique (adaptation locale). Mais ce qui manque souvent, c’est un niveau opérationnel technologique : la capacité à orchestrer, synchroniser et industrialiser l’innovation pour produire des effets cohérents dans la durée.

Dans ce domaine, l’opérationnel consiste à piloter un portefeuille, standardiser intelligemment (interfaces, données), tuer les impasses vite, et surtout “quarterbacker” l’intégration. Sans cela, on empile des POC comme on empilerait des bataillons sans plan de campagne. L’effet pervers est connu : les unités “innovent” localement, mais l’organisation ne capitalise pas. Résultat : beaucoup d’efforts, peu de puissance cumulée.

Des embryons existent : Task Force 99, par exemple, cherche à réduire drastiquement les cycles de conception et d’emploi de petits drones, avec des démonstrations où des airframes peuvent être conçus en minutes et imprimés/essayés en moins de 48 heures, au point de besoin. Ce type de structure n’est pas intéressant pour son folklore “startup”. Il est intéressant parce qu’il matérialise un niveau opérationnel : des boucles courtes, un feedback direct, une industrialisation progressive, et un lien explicite entre besoin tactique et production de capacité.

6️⃣ Une compétition systémique : R&D et intégration civil-militaire La compétition n’est pas seulement “qui a la meilleure techno”, mais “qui a la meilleure machine à produire et intégrer la techno”. Les volumes de R&D illustrent la dynamique : l’OCDE note que la Chine a atteint 96 % des dépenses R&D américaines en 2023 (en dollars PPA), contre 72 % dix ans plus tôt. La NSF confirme la place centrale des États-Unis et de la Chine dans les dépenses mondiales de R&D.

Côté organisation, la Military-Civil Fusion chinoise vise précisément à rendre mobilisable, à l’échelle d’un État, le transfert de technologies entre civil et militaire. Le rapport de la NBR décrit cette logique dual-use intégrée et la mise en valeur du potentiel militaire dans les capacités civiles. En clair : l’adversaire structure un pipeline d’innovation, là où nous empilons parfois des initiatives.

7️⃣ Acquisition : 12 ans, c’est trop long pour un domaine contesté Le diagnostic CSIS bute sur un point dur : la machine d’acquisition. Le GAO rappelle qu’en moyenne il faut près de 12 ans pour livrer une première capacité dans les grands programmes et insiste sur l’enjeu de “delivering capability with speed”. Dans une guerre de patchs et de contre-mesures, 12 ans, ce n’est pas un retard : c’est une abdication du tempo.

La réponse n’est pas “faire moins sérieux”, c’est changer de logique : modularité, incréments, gouvernance par l’usage, responsabilité d’architecture, et droit à la correction rapide. En langage de leadership : accepter de piloter le risque, plutôt que de prétendre l’éliminer sur PowerPoint.

8️⃣ Le “bouclier de silicium” : illustration parfaite… et ambiguë Le “silicon shield”, popularisé par Craig Addison au début des années 2000, postule que la centralité taïwanaise rendrait l’option militaire trop coûteuse. Il a une vertu pédagogique : il montre que la production industrielle de haute technologie est devenue un élément de dissuasion — donc un objet stratégique.

Mais il n’est pas une garantie automatique. Un papier académique (Chou, 2023) rappelle que ni les théories libérales ni les théories réalistes ne donnent une causalité mécanique entre interdépendance et paix ; tout dépend des attentes, des perceptions et des stratégies alternatives (hedging, relocalisation, coercition graduée).

C’est une nuance capitale pour la stratégie : l’interdépendance peut dissuader, mais elle peut aussi créer une “valeur de nuisance” si un acteur estime qu’une rupture future est inévitable ou acceptable. Dans ce cas, la chaîne de valeur devient un champ d’action : sanctions, contrôle des équipements, pressions sur les talents, perturbations cyber, démonstrations navales autour des routes logistiques… L’escalade peut être graduée, et pourtant stratégique.

9️⃣ Concentration du risque : Taïwan et l’hyper-centralité de TSMC Le Trade.gov détaille la dépendance : plus de 60 % du revenu mondial des fonderies, plus de 90 % du leading-edge, et une industrie pesant environ 20,7 % du PIB taïwanais. TrendForce ajoute un niveau de concentration intra-marché : TSMC atteint une part de marché record de 70,2 % au 2T 2025 (revenu fonderies).

Ce double niveau de concentration explique pourquoi le “silicon shield” est aussi un “point de défaillance systémique”. La relocalisation, d’ailleurs, n’est pas un interrupteur : recréer un écosystème leading-edge exige non seulement des fabs, mais des équipements, des matériaux, des compétences, des fournisseurs, et une discipline de production sur des années. Pendant cette transition, la dépendance continue d’exister — souvent avec moins de marge, parce qu’on a dispersé les ressources sans avoir encore déplacé le centre de gravité. La résilience ne se réduit pas à “reloc” : elle passe aussi par des stratégies de continuité (stocks, redondances, priorisation), par des architectures qui tolèrent la dégradation (mode dégradé, substitution), et par des coalitions industrielles capables de synchroniser les décisions (sinon chacun optimise sa souveraineté au détriment de la robustesse collective).

🔟 Leadership : ce que ce diagnostic impose, sans euphémisme Si la technologie est un domaine de combat, elle devient un objet de commandement. Cela impose quatre choix de leadership.

D’abord, une gouvernance opérationnelle de la technologie : arbitrage, architecture, interopérabilité, synchronisation doctrine-acquisition-cyber-industrie. Un domaine contesté sans commandement clair produit de la fragmentation, donc de la vulnérabilité.

Ensuite, une acquisition pensée comme boucle d’apprentissage, pas comme chaîne linéaire. La statistique du GAO doit être lue comme un signal : on ne pilote pas l’incertitude avec des jalons figés, mais avec des itérations mesurées, orientées effet.

Troisième choix : une stratégie industrielle et de talents assumée. Le “bouclier de silicium” rappelle que la capacité à produire est une condition de la liberté d’action. Diversifier, sécuriser, planifier la continuité, et former des profils hybrides deviennent des actes de stratégie.

Quatrième choix : travailler en coalition “par l’interface”, pas “par la déclaration”. Si l’Ukraine a montré quelque chose, c’est que les services commerciaux, les données et les architectures partagées accélèrent la décision. Une coalition moderne doit donc partager des standards techniques, des mécanismes de confiance (identités, clés, politiques), et des modèles de données — sinon elle reste une coalition de discours, pas de systèmes.

L’histoire militaire est pleine de rappels humiliants : quand une compétence technique devient décisive, il faut savoir l’intégrer vite. En 1918, l’armée américaine recrute des opératrices téléphoniques bilingues — les “Hello Girls” — parce que la téléphonie est devenue un facteur d’efficacité opérationnelle. Même logique aujourd’hui : data, logiciel, spectre, IA, production de semi-conducteurs. Le réflexe de leadership, ce n’est pas de “tolérer” ces compétences ; c’est de les mettre au cœur de la manœuvre.

1️⃣1️⃣ Et pour l’Europe : arrêter de confondre souveraineté et solitude Même si le CSIS parle d’abord aux États-Unis, la conclusion vaut pour l’Europe : on ne “souverainise” pas un domaine technologique en empilant des projets nationaux non compatibles. On le fait en construisant des architectures et des chaînes industrielles qui tiennent en crise.

Deux faits devraient vacciner contre la pensée magique. D’abord, l’Europe reste un acteur majeur, mais pas hégémonique : la NSF rappelle qu’en 2022, l’UE-27 représente une part significative des dépenses mondiales de R&D, loin derrière les deux premiers mais loin devant beaucoup d’autres. Ensuite, la valeur stratégique n’est pas seulement dans la recherche, mais dans la capacité à transformer vite la recherche en production, puis en intégration opérationnelle.

Concrètement, cela plaide pour une logique “coalition-by-design” : standards de données, interfaces communes, référentiels de cybersécurité, et surtout des “mission threads” (chaînes de mission) partagés, testés régulièrement en conditions dégradées. La résilience réelle ressemble rarement à un slogan ; elle ressemble à des exercices, des plans de continuité, des stocks intelligents, et des architectures pensées pour encaisser la perte d’un fournisseur, d’un lien ou d’un composant.

Conclusion

Le CSIS force une conclusion sans poésie : la guerre moderne se gagne aussi dans les architectures, les chaînes de production et les boucles d’apprentissage. Taïwan, via le “bouclier de silicium”, en est l’illustration la plus nette : une capacité industrielle civile devient un fait de dissuasion, une dépendance mondiale devient un centre de gravité, et la technologie devient un champ de bataille.

Le sujet n’est pas de “faire de la tech” en plus. Le sujet est de commander la manœuvre dans ce domaine, au bon tempo, avec une responsabilité explicite sur l’architecture, l’industrie et les talents. Sans cela, l’adversaire — ou le hasard — décidera à notre place. Et le hasard, fidèle à lui-même, n’a aucun sens du service public.

Références (sélection)

Trade.gov (2025) sur la place de Taïwan dans les fonderies et le leading-edge.

TrendForce (2025) sur la part de marché de TSMC.

GAO (2025) sur la vitesse d’acquisition.

OECD/NSF sur la dynamique des dépenses mondiales de R&D.

NBR (2021) sur la Military-Civil Fusion.

RUSI (2025) sur drones/EW en Ukraine.

GOV.UK (2022) sur OSINT et vitesse d’apprentissage.

Army.mil / Fort Monmouth sur les “Hello Girls”.

No-code / low-code et IA : des accélérateurs, pas un nouveau paradigme (et pourquoi DevSecOps restera la colonne vertébrale)

On entend parfois, avec l’aplomb tranquille de ceux qui n’ont jamais eu un incident en production : « Plus besoin de développeurs. » C’est une phrase simple, donc dangereuse. Parce qu’elle confond outil et paradigme.

Ma thèse (et je vais la marteler, gentiment) : le no-code/low-code n’est pas un nouveau paradigme du développement logiciel. C’est un outillage supplémentaire qui peut créer beaucoup de valeur sur certains segments, mais qui n’obère pas les méthodes d’ingénierie et d’industrialisation existantes — notamment DevSecOps. Et l’IA suit la même logique : gain évident, mais utile seulement si l’on possède le socle de compréhension et le cadre d’industrialisation.

1️⃣Outil vs paradigme : doctrine d’emploi, pas révélation mystique

Un paradigme, c’est une manière stable d’organiser la production et la responsabilité : architecture, qualité, sécurité, exploitation, gouvernance, compétences, et gestion du cycle de vie. Un outil, lui, change surtout le coût d’accès à certaines tâches.

Sur ce point, Gartner est étonnamment clair (et presque poétique pour un communiqué de presse) : le low-code est présenté comme l’évolution des outils de RAD vers le cloud/SaaS, pas une rupture ontologique. Et Gartner précise aussi que “no-code” n’est pas un critère suffisant : beaucoup de configurations “sans code” restent complexes et exigent des compétences spécialisées.

Donc, oui : on peut construire plus vite. Non : on ne supprime pas la gravité (ni la prod).

2️⃣ Ce que le no-code/low-code change réellement : l’accès et la vitesse

Le vrai bénéfice est là : réduire le délai entre une intention métier et une solution utilisable, surtout pour des apps internes simples (workflows, formulaires, automatisations, reporting). L’industrialisation ne disparaît pas, mais le prototypage et la réalisation “proche du métier” deviennent beaucoup plus accessibles.

Cette dynamique est massive : Gartner projette un marché mondial des technologies low-code à 26,9 Md$ en 2023 (+19,6% vs 2022) et souligne le rôle des “business technologists”.

Mais attention au piège stratégique : augmenter la vitesse de production augmente mécaniquement le nombre d’actifs logiciels à gouverner. Et là, les illusions commencent.

3️⃣ Ce que le no-code/low-code ne change pas (jamais) : les invariants du logiciel

Même sans écrire de code, dès que vous mettez en service une application, vous héritez des invariants :

Identité et habilitations, données (qualité, conformité, traçabilité), intégrations, tests (régression/sécurité), observabilité, gestion d’incidents, continuité, mises à jour, fin de support.

C’est précisément ce que structure le NIST SSDF (Secure Software Development Framework) : un socle de pratiques pour réduire les vulnérabilités à l’échelle du cycle de vie logiciel. Ce cadre s’applique indépendamment du langage… et donc indépendamment du “glisser-déposer”.

Traduction leadership : on peut simplifier l’assemblage, pas abolir la responsabilité.

4️⃣ Citizen developers : la productivité… ou le shadow IT industrialisé (selon votre gouvernance)

Gartner estime que d’ici 2026, les développeurs hors DSI représenteront au moins 80% de la base d’utilisateurs des outils low-code, contre 60% en 2021. C’est une excellente nouvelle… si vous avez un cadre. Sinon, c’est un multiplicateur de risques.

OWASP a consacré un Top 10 entier aux risques du citizen development (low-code/no-code, IA assistée, agents), avec un message simple : innovation distribuée = surface de risque distribuée si l’on ne gouverne pas (droits, données, configurations, inventaire, composants, etc.).

Ici, votre philosophie “pragmatisme” devient une règle de commandement : autonomie oui, anarchie non.

5️⃣ DevSecOps n’est pas “l’équipe qui code” : c’est la capacité d’industrialisation

Le contresens classique est de croire que DevSecOps est une “méthode de développeurs”. En réalité, DevSecOps est une capacité organisationnelle : livrer vite, de manière reproductible, traçable, observable, et sécurisée.

Le NIST (SP 800-204D) traite explicitement de l’intégration de la sécurité de la chaîne d’approvisionnement logicielle dans les pipelines CI/CD DevSecOps — autrement dit : la discipline de pipeline, de contrôles et de traçabilité devient structurante, pas optionnelle.

Et les organisations convergent vers la même logique avec la platform engineering : Gartner projette qu’en 2026, 80% des grandes organisations d’ingénierie logicielle auront des équipes dédiées, fournissant une “paved road” (voie balisée) via des plateformes et portails internes pour réduire la charge cognitive et standardiser l’exécution. DORA insiste sur la même idée : la plateforme abstrait la complexité, rend l’expérimentation plus sûre, et réduit le risque en rendant l’échec “moins cher” et la récupération plus rapide.

Donc non : le low-code ne remplace pas DevSecOps. Il renforce le besoin d’une ossature DevSecOps/plateforme, parce que vous allez produire plus, avec plus de producteurs.

6️⃣ IA et développement : gain évident, mais seulement si le socle existe

Le développement assisté par IA suit exactement la même logique que le low-code : accélérateur, pas paradigme. On obtient de la vitesse (boilerplate, tests, refactoring, documentation), mais la compétence de fond reste indispensable : cadrage, architecture, vérification, sécurité, exploitation.

Le NIST a même publié SP 800-218A, un profil SSDF pour les pratiques de développement sécurisé appliquées à la GenAI et aux modèles foundation “dual-use”. Message implicite : l’IA change la forme des risques, donc la discipline doit évoluer, pas disparaître. Et côté sécurité, le NCSC britannique rappelle que le prompt injection n’est pas une simple “SQL injection bis” : les différences sont cruciales et peuvent ruiner des mitigations naïves.

Pragmatisme, encore : l’IA est une puissance de feu. Sans doctrine d’emploi, c’est juste… un gros calibre pointé vers vos propres pieds.

7️⃣ Le pragmatisme comme boussole : “bon outil, bon périmètre, bon cadre”

Votre philosophie se résume en une règle opérationnelle : chaque solution a une zone de pertinence, et c’est le rôle du leadership de la définir.

- No-code/low-code : parfait pour accélérer des solutions simples, proches du métier, à criticité maîtrisée, sur une voie balisée.

- Dev “pro” : indispensable pour le cœur métier, les exigences de performance, la sécurité avancée, l’intégration complexe, le mission-critical.

- IA : excellente pour accélérer, explorer, automatiser… à condition d’un cadre de vérification et d’industrialisation (tests, revue, pipeline, observabilité, sécurité).

À noter : même les plateformes low-code sérieuses parlent désormais “garde-fous” (DLP, gouvernance des connecteurs, environnements). Microsoft décrit explicitement les politiques DLP comme des garde-fous pour réduire le risque d’exposition involontaire des données via connecteurs.

🧾Conclusion : vers une forge numérique (digital foundry)

Le no-code/low-code n’est pas un nouveau paradigme. L’IA non plus. Ce sont des outils puissants qui abaissent le coût de production sur certains segments — mais qui ne remplacent ni l’ingénierie, ni l’industrialisation, ni la responsabilité. Les cadres (SSDF), les exigences supply chain en CI/CD, et la montée de la platform engineering convergent vers la même vérité : la vitesse durable est un produit de la discipline.

L’ouverture logique, côté stratégie et leadership, c’est la création d’une forge numérique (digital foundry) : un cadre normé où citizen developers et développeurs professionnels se retrouvent, non pas pour se marcher dessus, mais pour co-produire sur une “paved road” sécurisée (identité, données, tests, observabilité, déploiement), avec une gouvernance qui accélère au lieu de freiner. Je m’arrête volontairement ici : cette forge numérique mérite un article à part entière — parce que c’est moins un sujet d’outils qu’un sujet de design organisationnel et de commandement.

Sources :

https://csrc.nist.gov/pubs/sp/800/218/final

https://csrc.nist.gov/pubs/sp/800/204/d/final

https://owasp.org/www-project-citizen-development-top10-security-risks

https://csrc.nist.gov/pubs/sp/800/218/a/final

https://www.ncsc.gov.uk/blog-post/prompt-injection-is-not-sql-injection

https://dora.dev/capabilities/platform-engineering

https://learn.microsoft.com/en-us/power-platform/admin/wp-data-loss-prevention

https://learn.microsoft.com/fr-fr/power-platform/guidance/coe/overview

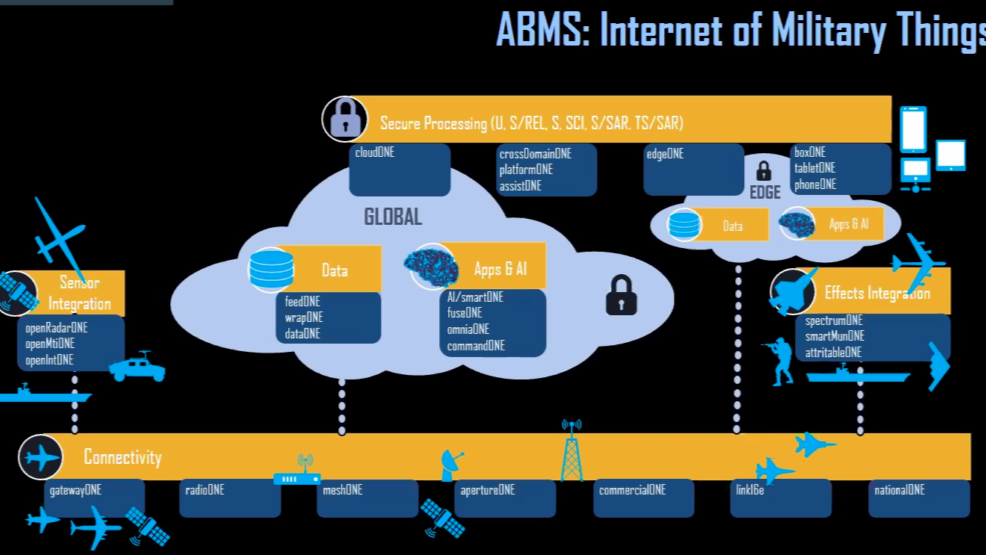

Le continuum numérique : ossature invisible des opérations multi-domaines

Il existe des images qui parlent mieux que de longs discours. Celle que j’utilise régulièrement pour expliquer le continuum numérique en fait partie.

Elle a ceci de précieux qu’elle rend concret ce qui est trop souvent abordé de manière abstraite : un continuum numérique parfaitement intégré au continuum opérationnel, des capteurs jusqu’aux effecteurs — et inversement, des opérations vers le numérique, dans une relation bidirectionnelle permanente.

Cette image met en évidence une réalité structurante : 👉 le numérique n’est pas un support des opérations, il en est désormais une dimension constitutive.

Le continuum numérique n’est pas un “support”

Il est consubstantiel aux opérations

Une erreur encore fréquente consiste à considérer le numérique comme :

- une fonction de soutien modernisée,

- une couche technologique ajoutée après coup,

- ou un simple facilitateur.

Cette vision est aujourd’hui dépassée.

👉 Le numérique et l’opérationnel ne sont plus deux mondes distincts. Ils forment un continuum unique, dans lequel :

- l’opération génère la donnée,

- la donnée structure la compréhension,

- la compréhension éclaire la décision,

- la décision transforme l’action,

- et l’action rétroagit en permanence sur le numérique.

Il n’existe plus de frontière nette entre systèmes numériques et systèmes de combat.

Du capteur à l’effecteur : une continuité non négociable

La force de l’image est de montrer que :

- les capteurs sont déjà du numérique,

- les effecteurs sont pilotés par l’information,

- la décision est un acte humain augmenté, mais jamais remplacé, par la technologie.

👉 La technologie n’est pas au milieu de la manœuvre : elle en est la matière première.

Sans capteurs, pas de données. Sans données, pas de compréhension. Sans compréhension, pas de décision pertinente. Sans décision, pas d’effets coordonnés.

Dans les opérations multi-domaines, rompre cette continuité, même localement, c’est rompre la manœuvre.

L’IA et le cloud : accélérateurs, pas fondations

Cette représentation permet de remettre à leur juste place deux notions souvent survalorisées.

L’IA

L’intelligence artificielle :

- accélère l’analyse,

- révèle des corrélations,

- réduit la charge cognitive,

- soutient la priorisation.

Mais elle ne crée rien par elle-même. Elle dépend entièrement :

- des données issues des capteurs,

- de leur qualité,

- de leur contextualisation opérationnelle.

Le cloud

Le cloud n’est ni une fin, ni une solution autonome.

Un cloud sans capteurs est vide. Un cloud sans connectivité est muet. Un cloud sans infrastructures déployées et sécurisées est inutilisable.

👉 Le cloud n’a de valeur que lorsqu’il est ancré dans la réalité opérationnelle.

Les infrastructures numériques : la ligne de front oubliée

La partie basse de l’image est sans doute la plus sous-estimée — et pourtant la plus critique.

Réseaux tactiques, SATCOM, maillages, interconnexions interalliées, solutions opportunistes : ce socle numérique est directement soumis aux lois de la guerre :

- brouillage,

- dégradation,

- destruction,

- saturation.

👉 La connectivité n’est pas un prérequis technique. 👉 C’est un champ de bataille à part entière.

Le continuum numérique ne doit donc pas être pensé pour un environnement idéal, mais pour un environnement dégradé, contesté et instable.

Le spectre électromagnétique : une ressource critique et disputée

À cette réalité s’ajoute un facteur souvent sous-estimé : le spectre électromagnétique.

Toute opération numérique — capteurs, communications, données, effets — repose sur un accès au spectre, par nature fini, contraint et disputé. Dans un cadre multinational, ce spectre est déjà fortement sollicité et parfois limité par :

- des règles de coordination interalliées,

- des contraintes nationales,

- la coexistence de systèmes hétérogènes.

Face à l’adversaire, il devient un espace de confrontation à part entière, soumis au brouillage, à la déception, à la saturation et à la captation.

👉 Sans maîtrise du spectre électromagnétique, le continuum numérique se fragilise, quelle que soit la sophistication des architectures. La supériorité numérique passe donc autant par la gestion dynamique du spectre que par la performance des systèmes qui l’exploitent.

Encadré – Idées reçues sur le continuum numérique et les opérations MDO

❌ « Le continuum numérique, c’est surtout du cloud et de l’IA » ✅ Le cloud et l’IA ne sont que des accélérateurs. Sans données issues des capteurs, sans connectivité résiliente, sans infrastructures déployées, ils ne produisent aucune valeur opérationnelle.

❌ « Le numérique est un soutien aux opérations » ✅ Le numérique fait partie intégrante de la manœuvre. Dans les MDO, il n’y a plus de frontière claire entre système numérique et système de combat.

❌ « L’IA permettra de décider plus vite que l’humain » ✅ L’IA n’est pas un décideur. Elle assiste, éclaire, propose. La décision reste humaine, surtout dans un environnement dégradé.

❌ « Une bonne architecture garantit la supériorité numérique » ✅ Aucune architecture ne résiste seule à la guerre électronique et à la saturation. La supériorité repose sur la capacité à opérer malgré la dégradation.

❌ « Le continuum numérique est un projet technologique » ✅ C’est avant tout un projet humain, organisationnel et culturel.

Encadré – Idées reçues sur le spectre électromagnétique

❌ « Le spectre est un sujet purement technique » ✅ Le spectre est un enjeu opérationnel majeur, au même titre que le terrain ou le temps.

❌ « Le spectre est disponible tant qu’on a les bons équipements » ✅ Le spectre est une ressource rare, contrainte par la coalition et activement contestée par l’adversaire.

❌ « La supériorité spectrale se décrète » ✅ Elle se manœuvre : allocation dynamique, priorisation, arbitrage temps réel.

❌ « Le spectre concerne uniquement les spécialistes guerre électronique » ✅ Toute capacité numérique en dépend : capteurs, données, commandement, effets.

❌ « Le spectre est un problème annexe du numérique » ✅ Sans maîtrise du spectre, le continuum numérique se désagrège.

Encadré – La Fabrique numérique (Digital Foundry) : garder le continuum vivant

Un continuum numérique parfaitement conçu mais figé est un continuum déjà obsolète.

Les opérations multi-domaines évoluent plus vite que les cycles d’acquisition, et la menace s’adapte plus vite que les architectures.

👉 La Fabrique numérique (Digital Foundry) est le mécanisme qui permet d’adapter en continu le continuum aux besoins réels des opérations.

Elle n’est :

- ni un laboratoire hors-sol,

- ni une DSI rebaptisée,

- ni une usine à démonstrateurs.

Elle est un dispositif d’agilité opérationnelle, permettant :

- l’intégration rapide de nouveaux capteurs ou sources de données,

- l’ajustement des chaînes de traitement et de fusion,

- l’évolution des aides à la décision selon les usages terrain,

- l’expérimentation locale sans casser l’architecture globale,

- la réduction drastique du délai entre besoin opérationnel et capacité déployable.

👉 La Fabrique numérique agit comme un mécanisme d’auto-adaptation du continuum, en phase avec la boucle OODA elle-même.

Une boucle OODA rendue visible et tangible

Cette image a une autre force majeure : elle rend concrète et lisible la boucle OODA, souvent citée mais rarement incarnée.

- Observer : capteurs multi-domaines

- Orienter : fusion des données, contextualisation, IA

- Décider : commandement humain augmenté

- Agir : effets coordonnés, multi-domaines

👉 Le continuum numérique est la matérialisation de la boucle OODA.

Mais surtout, il montre que la boucle est fermée dans les deux sens :

- l’opération influence la donnée,

- la donnée influence la décision,

- la décision reconfigure le numérique.

Le grand absent de l’image : l’humain

Cette représentation est volontairement technologique. Mais elle masque le facteur décisif : les femmes et les hommes.

Sans :

- talents numériques acculturés à l’opérationnel,

- opérationnels comprenant les contraintes techniques,

- leaders capables d’arbitrer entre vitesse, sécurité et résilience,

👉 le continuum se fragmente.

La continuité numérique-opérationnelle est avant tout une continuité de compétences, de langage et de culture.

Pour conclure : continuité, adaptation, décision

Le continuum numérique garantit la continuité. La Fabrique numérique assure l’adaptation. La boucle OODA donne le rythme. La maîtrise du spectre conditionne l’ensemble.

Ensemble, ils permettent de :

- maintenir l’alignement entre intention opérationnelle et capacités numériques,

- décider plus vite que la désorganisation adverse,

- transformer le numérique en véritable manœuvre.

Le numérique ne transforme pas les opérations. Il révèle la capacité d’une organisation à s’adapter en continu sous contrainte.

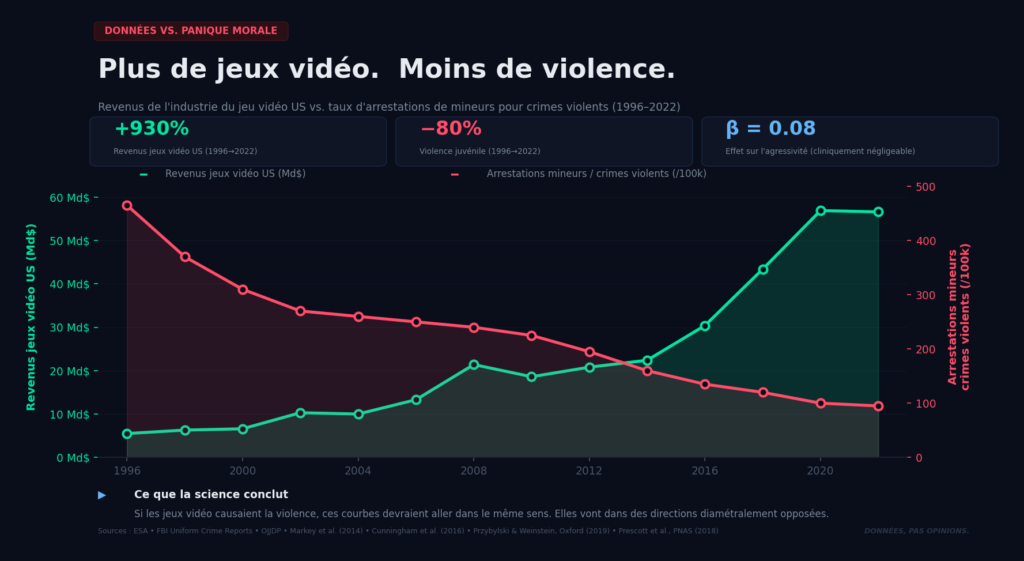

Non, les jeux vidéo ne rendent pas violent. Et ce n’est pas moi qui le dis — c’est 25 ans de recherche scientifique.

À chaque fusillade, le réflexe est le même. On fouille la chambre du tireur. On y trouve une console. Et le procès est plié.

GTA. Call of Duty. Fortnite. Les suspects habituels.

Sauf qu’il y a un problème : la science a creusé cette question pendant un quart de siècle. Plus de 130 000 participants étudiés. Des dizaines de méta-analyses. Des chercheurs d’Oxford, Harvard, l’APA, le PNAS.

Et le verdict est sans appel.

🔬 Ce que dit réellement la recherche

En 2019, l’Oxford Internet Institute publie l’une des études les plus rigoureuses jamais menées sur le sujet. Étude pré-enregistrée (impossible de trafiquer les résultats après coup), 1 004 adolescents britanniques, évaluations croisées parents-enfants, classification officielle PEGI/ESRB de la violence des jeux.

Résultat : zéro corrélation entre temps passé sur des jeux violents et comportement agressif.

Le Pr. Andrew Przybylski, directeur de recherche à Oxford, résume : « Malgré l’intérêt des parents et des décideurs, la recherche n’a pas démontré qu’il y avait lieu de s’inquiéter. »

En 2020, c’est l’American Psychological Association elle-même — celle qui avait alimenté le débat en 2015 — qui rétropédale. Déclaration officielle : preuves insuffisantes pour établir un lien entre jeux vidéo et violence dans le monde réel.

Et quand Ferguson, Copenhaver & Markey ont réanalysé le fameux rapport APA de 2015 ? Ils ont trouvé des biais de publication systématiques, des mesures d’agressivité qui n’ont rien à voir avec la violence réelle (infliger du bruit à un adversaire en labo ≠ passer à l’acte), et un effet qui s’effondre une fois corrigé.

📉 Le chiffre qui tue le débat

Pendant que les ventes de jeux vidéo explosaient depuis les années 90, la violence juvénile aux États-Unis chutait de plus de 80% (FBI Uniform Crime Reports).

Cunningham, Engelstätter & Ward (2016) sont allés plus loin avec une méthodologie quasi-expérimentale : chaque hausse de 1% des ventes de jeux violents est associée à une baisse de 0.03% de la criminalité violente.

Vous avez bien lu. Plus de jeux violents = moins de crimes violents.

L’explication ? L’« effet d’incapacitation ». Un joueur plongé dans 60 heures d’Elden Ring, c’est un joueur qui n’est pas dehors. Le temps passé à jouer se substitue à des activités extérieures potentiellement risquées.

🧠 « Mais il y a quand même un petit effet sur l’agressivité ? »

Oui. Soyons honnêtes.

La méta-analyse de Prescott et al. (PNAS, 2018) — 24 études longitudinales, 17 000+ participants — trouve un effet statistiquement significatif sur l’agressivité : β = 0.078.

Traduction concrète : cet effet explique moins de 1% de la variance du comportement agressif. C’est l’équivalent statistique d’un bruit de fond. C’est mesurable, mais cliniquement négligeable. Et surtout : « agressivité » en labo signifie crier ou pousser — pas commettre un crime.

L’APA le dit elle-même : tout au plus, on parle de « crier et pousser ». Pas exactement le profil d’un tueur de masse.

🎯 Alors, d’où vient réellement la violence ?

La recherche est très claire sur les vrais prédicteurs :

→ Violence intrafamiliale — Ferguson et al. (2008) : c’est le prédicteur n°1 de la criminalité violente. Pas les jeux.

→ Troubles de la personnalité préexistants — Les traits agressifs précèdent le jeu, ils ne sont pas créés par lui.

→ Traumatismes de l’enfance — Sanchez & Ferguson (2022) ont analysé 169 auteurs de fusillades de masse. Résultat : ils n’avaient pas joué plus aux jeux violents que la population générale. En revanche, ils avaient subi significativement plus de violences familiales.

→ Accès aux armes à feu — Le Japon et la Corée du Sud consomment autant de jeux violents que les États-Unis. Leur taux de fusillades ? Quasi nul. La variable, ce n’est pas le jeu. C’est le fusil.

💡 Pourquoi ça compte

Pointer les jeux vidéo, c’est confortable. C’est un coupable idéal : visible, nouveau, mal compris par les décideurs.

Mais c’est aussi dangereux. Parce que chaque minute passée à débattre de GTA est une minute pas passée à financer la santé mentale, à lutter contre les violences domestiques, ou à réguler l’accès aux armes.

Kutner & Olson (Harvard, 2008) le résumaient parfaitement : « Se focaliser sur des cibles faciles comme les jeux vidéo violents empêche les parents, activistes et décideurs de s’attaquer aux causes bien plus puissantes de la violence juvénile. »

3,2 milliards de joueurs dans le monde. Si les jeux vidéo rendaient violent, on le saurait.

Il est temps de lâcher le joystick du bouc émissaire et de s’attaquer aux vraies causes.

📚 Sources :

- Przybylski & Weinstein (2019) — Royal Society Open Science, Oxford Internet Institute

- Prescott, Sargent & Hull (2018) — PNAS, méta-analyse longitudinale

- Ferguson, Copenhaver & Markey (2020) — Perspectives on Psychological Science

- Cunningham, Engelstätter & Ward (2016) — Southern Economic Journal

- Sanchez & Ferguson (2022) — Journal of Mass Violence Research

- Kutner & Olson (2008) — Grand Theft Childhood, Harvard

- APA (2020) — Déclaration révisée sur jeux vidéo et violence

- Markey, Markey & French (2014) — Psychology of Popular Media Culture

- Mathur & VanderWeele (2019) — Perspectives on Psychological Science

De l’Aristocratie Technologique à la Masse Attritionnable : La Leçon de 2010 face aux Guerres de 2026

Le Hors-Série n°10 de DSI (2010) n’était pas seulement une revue technique, mais un manifeste stratégique dont les prophéties se sont heurtées à l’inertie des modèles de force occidentaux. Alors que les auteurs de l’époque appelaient à un « échange travail/capital », nous avons persisté dans la préservation d’armées « aristocratiques », rares et chères. En 2026, la rupture ne réside plus dans le robot lui-même, mais dans sa capacité à alimenter un Jumeau Numérique du champ de bataille, permettant une accélération sans précédent de la boucle OODA grâce à des systèmes attritionnables.

I. LE PARADIGME DE 2010

En 2010, la robotique militaire basculait de l’expérimentation vers l’industrialisation massive. Joseph Henrotin y identifiait les forces motrices qui dictent aujourd’hui la manœuvre :

- Le Facteur Socioculturel : Le soldat et le général de 2026 sont les enfants de la « culture geek » décrits en 2010. Leur compréhension intuitive de l’informatique permet d’envisager l’interface homme-machine non plus comme une contrainte, mais comme une extension cognitive.

- La Trinité des Milieux :

- Air : Le drone comme vecteur de persistance (MALE).

- Mer : La « marsupialisation » (bâtiments mères), concept alors visionnaire de Thales et ECA.

- Terre : La reconnaissance de la « viscosité » du terrain, identifiée comme le défi majeur de l’autonomie tactique.

II. LES VOIX QUE NOUS N’AVONS PAS ÉCOUTÉES

Trois experts livraient des analyses qui constituent aujourd’hui le socle de l’OSINT (Open Source Intelligence) sur les théâtres contemporains :

- P.W. Singer (La Guerre Open Source) : Il annonçait la fin du monopole étatique sur la haute technologie. “La guerre devient « open source » […] Quelqu’un a construit une version du Raven pour à peine 1 000 dollars.” La munition rôdeuse artisanale et le drone FPV sont les héritiers directs de cette vision.

- Michel Goya (L’Armée Aristocratique) : Il dénonçait la fragilité des armées d’échantillons. En privilégiant la sophistication unitaire, nous avons perdu la capacité d’usure. Le robot devait être l’outil de la masse ; il est resté, par conservatisme, un objet précieux.

- Bernard Pikeroen (Souveraineté Industrielle) : Il prévenait que sans stratégie européenne de transfert industriel, nous serions vassalisés par les technologies étrangères.

III. POURQUOI SOMMES-NOUS EN RETARD ?

Le constat est sans appel : si nous sommes aujourd’hui à la traîne sur la masse et la souveraineté, c’est pour trois raisons identifiées dès 2010 mais ignorées :

- Le Déni du Caractère Attritionnable : Nous avons continué à construire des drones comme des avions (chers, rares). L’OSINT en Ukraine ou en Mer Noire montre que l’efficacité réside dans la consommabilité. Un système attritionnable n’est pas un système “bas de gamme”, c’est un système dont le coût permet de saturer les défenses adverses.

- La Naïveté du Signal : Le magazine mentionnait le piratage des flux vidéo à 18$. Nous avons ignoré cette alerte. En 2026, la guerre électronique (EW) rend caducs nos systèmes trop dépendants du GPS et des liaisons de données centralisées.

- L’Inertie du Transfert Industriel : Le “patinage” des programmes de drones européens décrit en 2010 a conduit à une dépendance durable envers les systèmes dont nous ne maîtrisons ni le code source, ni le calendrier d’évolution.

IV. DU ROBOT-OBJET AU JUMEAU NUMÉRIQUE

C’est ici que se situe la véritable rupture par rapport à 2010. Le robot n’est plus une “entité physique isolée”, il est le terminal nerveux d’une intelligence globale.

La Proposition : La Guerre des Jumeaux Numériques La force réside désormais dans la capacité à générer un “Digital Twin” du champ de bataille en temps réel grâce à des milliers de micro-capteurs robotisés attritionnables (terrestres, aériens, maritimes) :

- Synthèse Totale : Chaque capteur devient un pixel d’une image globale mise à jour chaque seconde.

- Hyper-OODA : L’intelligence artificielle traite cette masse de données pour réduire le délai entre l’observation et l’action à quelques secondes, permettant une prise de décision hyper-accélérée.

- Visualisation et Simulation : Le Jumeau Numérique permet de simuler des options tactiques et de saturer l’ennemi dans le réel après l’avoir vaincu dans le virtuel.

V. POUR UNE STRATÉGIE DE PUISSANCE (2026-2040)

Pour reprendre l’initiative stratégique, nous devons décliner les propositions suivantes :

- 1. Doctrine de la Masse Attritionnable : Passer du “zéro perte” au “sacrifice calculé des machines”. Produire des essaims de drones dont la perte est intégrée à la manœuvre pour saturer économiquement les systèmes sol-air adverses.

- 2. Souveraineté du Code et des Algorithmes : Nationaliser les bibliothèques d’IA de ciblage. La souveraineté ne réside plus dans la cellule du drone, mais dans les modèles de reconnaissance de formes et de navigation sans GPS (SLAM).

- 3. Intelligence Distribuée (Edge Computing) : Développer des essaims autonomes capables de décider en local pour contrer le déni d’accès (A2/AD) et le brouillage des communications.

- 4. Robotisation Logistique Intégrale : Déployer massivement des “mules” terrestres pour redonner au fantassin sa fonction de commandement en l’allégeant de la “viscosité” physique du terrain.

CONCLUSION : LA FIN DE L’ENTITÉ ISOLÉE

Le magazine de 2010 nous avait fourni le diagnostic ; nous avons échoué sur l’ordonnance. En 2026, l’innovation ne réside plus dans l’objet qui tire, mais dans le réseau qui voit, comprend et décide. Le futur de la guerre n’est plus une armée de Terminators, mais une nuée de capteurs attritionnables créant un double numérique du réel.

La victoire appartient désormais à celui qui générera le Jumeau Numérique le plus fidèle et le plus rapide pour dominer la boucle OODA.

#DefenseTech #Strategie #Attritionnable #Masse #OODA #DigitalTwin #DSI2010 #GuerreDuFutur