Pourquoi l’IA ne rend pas “idiot” — mais pourquoi un mauvais usage peut affaiblir l’intelligence collective

L’intelligence artificielle (IA), notamment sous sa forme générative, est devenue en un temps très court un outil de production intellectuelle puissant. Cette diffusion rapide alimente deux narratifs opposés : l’enthousiasme (promesse de gains considérables de productivité) et l’inquiétude (peur d’une substitution de l’humain et d’une perte de contrôle).

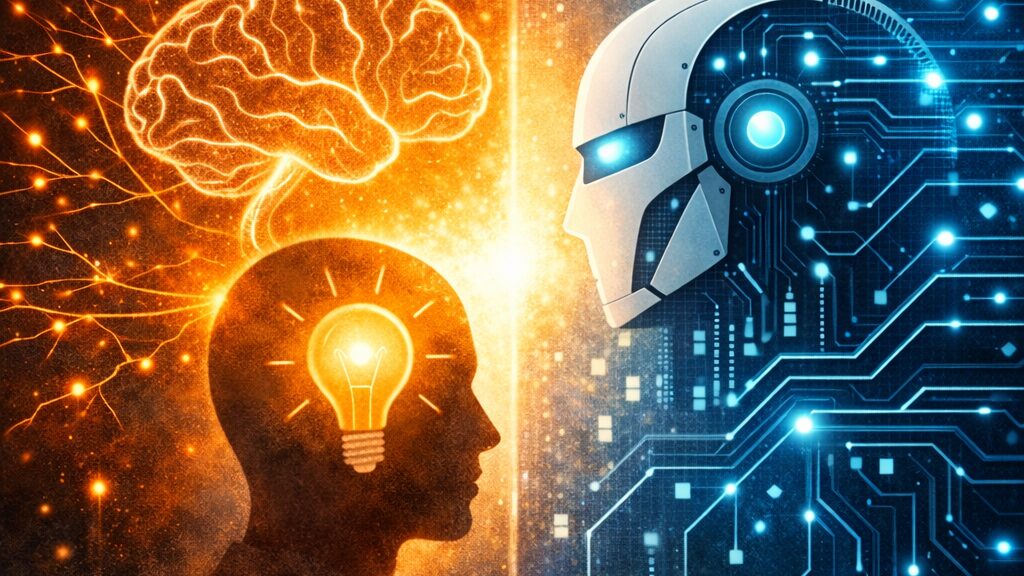

Pourtant, une approche plus rigoureuse conduit à reformuler le problème. L’IA n’a pas vocation à rendre “idiot” par nature. Elle ne possède ni intention, ni volonté, ni stratégie. En revanche, l’usage que nous en faisons peut renforcer nos compétences… ou les fragiliser.

Autrement dit, le cœur du sujet n’est pas la technologie elle-même, mais ce qu’elle transforme dans une organisation : la manière dont on apprend, dont on raisonne, dont on vérifie et dont on décide. Dès lors, l’IA relève moins d’un débat “outil” que d’une question de leadership et de management du capital cognitif.

1. Le principe structurant : l’organisation pense d’abord par ses humains

Une organisation n’est pas “intelligente” parce qu’elle dispose d’outils performants. Elle l’est parce qu’elle mobilise durablement des capacités humaines qui constituent son capital immatériel :

- la connaissance (savoirs structurés, savoir-faire, compréhension des fondamentaux)

- l’expérience (maîtrise du contexte, mémoire des contraintes et des conséquences)

- l’esprit critique (capacité à évaluer, comparer, douter, vérifier)

- l’innovation (exploration d’options, créativité, recombinaisons pertinentes)

- l’authenticité (capacité à engager, incarner, fédérer)

- la diversité (richesse des points de vue, correction des angles morts)

L’IA peut contribuer à amplifier ce capital. Elle peut accélérer la production, améliorer la mise en forme, élargir l’exploration. Mais elle ne peut ni remplacer l’expérience, ni assumer la responsabilité, ni garantir le discernement. C’est pourquoi l’IA doit être considérée comme un amplificateur : elle renforce les organisations solides, et peut tout autant amplifier les fragilités d’un collectif insuffisamment outillé.

2. Une condition préalable : on n’utilise pas l’IA sans fondations

La pertinence de l’usage de l’IA dépend d’un prérequis trop souvent implicite : pour tirer parti de l’IA, il faut déjà disposer d’un socle cognitif minimal.

Ce socle est principalement formé par l’éducation et l’apprentissage de base :

- compréhension du langage et précision lexicale

- structuration d’arguments et raisonnement

- distinction faits / hypothèses / interprétations

- méthode, logique, rigueur

- premières compétences disciplinaires (métier, technique, juridique, etc.)

Sans ce socle, l’IA peut produire des résultats “propres” en apparence, mais l’utilisateur n’est pas en mesure de vérifier, de contextualiser, ni de défendre. Le risque n’est pas que l’IA “rende idiot”, mais qu’elle devienne un substitut d’effort, conduisant à une dépendance progressive et à une fragilisation de l’autonomie intellectuelle.

3. Le risque managérial : confondre performance immédiate et capacité durable

L’IA offre un gain de temps réel. Toutefois, un usage passif peut conduire à un paradoxe organisationnel : l’augmentation des livrables n’implique pas nécessairement l’augmentation de la compétence.

On peut produire plus vite tout en :

- réduisant la profondeur de compréhension,

- diminuant l’apprentissage par la pratique,

- limitant l’exercice critique,

- fragilisant la capacité de décision autonome.

Dans cette logique, la question n’est pas la productivité ponctuelle, mais la capacité durable d’une organisation à apprendre et à s’adapter. Une organisation qui ne renforce plus ses compétences devient mécaniquement plus vulnérable face à l’incertitude, aux ruptures et aux crises.

4. L’illusion centrale : l’IA rendrait automatiquement tout le monde meilleur

L’IA ne rend pas mécaniquement plus compétent. Elle amplifie le niveau réel de l’utilisateur et la maturité du collectif.

- Chez un profil expert, elle accélère la mise en forme, la recherche d’options, la vérification, l’exploration de scénarios.

- Chez un profil en construction, elle peut créer une illusion de maîtrise en produisant un résultat sans compréhension des fondamentaux.

La conséquence est managériale : l’IA ne doit pas être déployée comme une simple solution de productivité, mais comme un levier inscrit dans une politique de développement des compétences, de contrôle et d’apprentissage collectif.

5. Leadership et gouvernance : faire de l’IA un levier sans externaliser l’expertise

Le leadership responsable n’a pas pour objectif de freiner l’IA, mais de cadrer son usage afin qu’elle augmente l’intelligence collective plutôt qu’elle ne la fragilise.

Deux dérives sont particulièrement critiques :

5.1. La délégation de la pensée

Lorsque l’IA devient un substitut à l’effort de structuration, de raisonnement ou de vérification, les compétences s’érodent. L’outil n’est pas fautif : c’est l’usage qui installe une dépendance.

5.2. La boîte noire et la dilution de responsabilité

Lorsque les livrables IA sont adoptés sans appropriation, la responsabilité devient floue. Or la performance organisationnelle repose sur la capacité à expliquer, défendre et assumer des décisions.

Le rôle du manager consiste donc à imposer un principe directeur simple :

L’IA doit être un “sparring partner” qui fait progresser, pas un pilote automatique qui remplace.

🔲 Encadré — Pilotage managérial : IA comme sparring partner (règles d’équipe et garde-fous)

Objectif : faire de l’IA un accélérateur de compétences et de décision, sans créer de dépendance ni externaliser l’expertise.

1) Trois usages prioritaires

✅ Clarifier : structurer, reformuler, expliciter les hypothèses ✅ Explorer : options, scénarios, risques, angles morts ✅ S’entraîner : cas pratiques, quiz, simulation de contradicteur 🚫 À éviter : décider à notre place / livrer final sans appropriation.

2) Règle “No Answer First”

Avant l’IA : objectif (1 phrase), hypothèse (1 phrase), contraintes (3 points). 👉 Si l’on ne sait pas le formuler, l’IA risque de penser à notre place.

3) Protocole de sparring

Prompt standard :

“Agis comme un coach exigeant. Ne donne pas la réponse immédiatement. Pose 5 questions structurantes. Propose ensuite 2 pistes. Puis demande-moi d’arbitrer et de justifier.”

4) Accountability : un responsable humain

Tout livrable assisté par IA doit avoir un owner. Pas d’owner = pas de livrable.

5) Vérifiabilité : condition de diffusion

Le livrable doit expliciter : hypothèses, limites, points à vérifier, connaissance interne mobilisée.

6) Différenciation junior/senior

- Junior : usage guidé + validation sur fondamentaux

- Senior : usage d’accélération + “signature humaine” (arbitrage, nuance, décision)

7) Rituels d’apprentissage

Revue de prompts (hebdo), analyse d’erreurs (bimensuelle), “red team” (mensuelle).

8) Indicateurs

Qualité de décision, autonomie, robustesse, innovation. Si la vitesse augmente mais que l’autonomie diminue : alerte.

Mantra : l’IA augmente la production ; le management doit augmenter la compétence.

Conclusion : l’IA amplifie, l’humain structure et décide

L’IA n’est pas un facteur d’idiotie. Elle est un facteur d’accélération. Ce qui fragilise une organisation, ce n’est pas l’IA : c’est l’abandon du socle cognitif et de l’esprit critique au profit d’un résultat immédiat.

Le futur distinguera moins ceux qui “utilisent l’IA” de ceux qui ne l’utilisent pas, que ceux qui auront su maintenir et renforcer :

- l’apprentissage,

- l’autonomie,

- la responsabilité,

- la capacité de jugement.

La question n’est donc pas : faut-il adopter l’IA ? Elle devient :

Comment renforcer les fondamentaux (éducation, savoirs, esprit critique),et instaurer un cadre managérial qui transforme l’IA en levier,sans affaiblir l’autonomie cognitive de l’organisation ?

#Leadership #Management #IntelligenceArtificielle #Apprentissage #PenséeCritique